Hashmap是Java中非常常用的容器,在网上看见很多源码分析都是以前版本的,本文章结合JDK1.8的源码对HashMap进行简单的分析,在学习的过程中发现HashMap的源码远比前面的List要复杂的多,花了好长时间才理清关系。

O、哈希函数的构造方法与冲突处理

在面试的时候经常见到哈希冲突的解决方法,所以在分析HashMap之前,加入了这部分。

哈希法又称散列法、杂凑法以及关键字地址计算法等,相应的表称为哈希表。这种方法的基本思想是:首先在元素的关键字k和元素的存储位置p之间建立一个对应关系f,使得p=f(k),f称为哈希函数。创建哈希表时,把关键字为k的元素直接存入地址为f(k)的单元;以后当查找关键字为k的元素时,再利用哈希函数计算出该元素的存储位置p=f(k),从而达到按关键字直接存取元素的目的。

1、哈希函数的构造方法

构造哈希函数的原则是:

- 函数本身便于计算

- 计算出来的地址分布均匀,即对任一关键字k,f(k) 对应不同地址的概率相等,目的是尽可能减少冲突。

主要有一下集中方法:

- 数字分析法

- 平方取中法

- 分段叠加法

- 除留余数法

- 伪随机数法

1.1、数字分析法

如果事先知道关键字集合,并且每个关键字的位数比哈希表的地址码位数多时,可以从关键字中选出分布较均匀的若干位,构成哈希地址。例如,有80个记录,关键字为8位十进制整数d1d2d3…d7d8,如哈希表长取100,则哈希表的地址空间为:00~99。假设经过分析,各关键字中 d4和d7的取值分布较均匀,则哈希函数为:h(key)=h(d1d2d3…d7d8)=d4d7。例如,h(81346532)=43,h(81301367)=06。相反,假设经过分析,各关键字中 d1和d8的取值分布极不均匀, d1 都等于5,d8 都等于2,此时,如果哈希函数为:h(key)=h(d1d2d3…d7d8)=d1d8,则所有关键字的地址码都是52,显然不可取。

1.2、平方取中法

当无法确定关键字中哪几位分布较均匀时,可以先求出关键字的平方值,然后按需要取平方值的中间几位作为哈希地址。这是因为:平方后中间几位和关键字中每一位都相关,故不同关键字会以较高的概率产生不同的哈希地址。

例:我们把英文字母在字母表中的位置序号作为该英文字母的内部编码。例如K的内部编码为11,E的内部编码为05,Y的内部编码为25,A的内部编码为01, B的内部编码为02。由此组成关键字“KEYA”的内部代码为11052501,同理我们可以得到关键字“KYAB”、“AKEY”、“BKEY”的内部编码。之后对关键字进行平方运算后,取出第7到第9位作为该关键字哈希地址

| 关键字 | 内部编码 | 内部编码的平方值 | H(k)关键字的哈希地址 |

|---|---|---|---|

| KEYA | 11050201 | 122157778355001 | 778 |

| KYAB | 11250102 | 126564795010404 | 795 |

| AKEY | 01110525 | 001233265775625 | 265 |

| BKEY | 02110525 | 004454315775625 | 315 |

1.3、分段叠加法

这种方法是按哈希表地址位数将关键字分成位数相等的几部分(最后一部分可以较短),然后将这几部分相加,舍弃最高进位后的结果就是该关键字的哈希地址。具体方法有折叠法与移位法。移位法是将分割后的每部分低位对齐相加,折叠法是从一端向另一端沿分割界来回折叠(奇数段为正序,偶数段为倒序),然后将各段相加。例如:key=12360324711202065,哈希表长度为1000,则应把关键字分成3位一段,在此舍去最低的两位65,分别进行移位叠加和折叠叠加,求得哈希地址为1105和907

1 2 3 1 2 3

6 0 3 3 0 6

2 4 7 2 4 7

1 1 2 2 1 1

+) 0 2 0 +) 0 2 0

———————— —————————

1 1 0 5 9 0 7

(a)移位叠加 (b) 折叠叠加

1.4、除留余数法

假设哈希表长为m,p为小于等于m的最大素数,则哈希函数为

h(k)=k % p ,其中%为模p取余运算。

例如,已知待散列元素为(18,75,60,43,54,90,46),表长m=10,p=7,则有

h(18)=18 % 7=4 h(75)=75 % 7=5 h(60)=60 % 7=4

h(43)=43 % 7=1 h(54)=54 % 7=5 h(90)=90 % 7=6

h(46)=46 % 7=4

此时冲突较多。为减少冲突,可取较大的m值和p值,如m=p=13,结果如下:

h(18)=18 % 13=5 h(75)=75 % 13=10 h(60)=60 % 13=8

h(43)=43 % 13=4 h(54)=54 % 13=2 h(90)=90 % 13=12

h(46)=46 % 13=7

1.5、伪随机数法

采用一个伪随机函数做哈希函数,即h(key)=random(key)。

在实际应用中,应根据具体情况,灵活采用不同的方法,并用实际数据测试它的性能,以便做出正确判定。通常应考虑以下五个因素 :

l 计算哈希函数所需时间 (简单)。

l 关键字的长度。

l 哈希表大小。

l 关键字分布情况。

l 记录查找频率

2、哈希冲突的解决方法

通过构造性能良好的哈希函数,可以减少冲突,但一般不可能完全避免冲突,因此解决冲突是哈希法的另一个关键问题。创建哈希表和查找哈希表都会遇到冲突,两种情况下解决冲突的方法应该一致。下面以创建哈希表为例,说明解决冲突的方法。常用的解决冲突方法有以下四种:

- 开放地址法

- 再哈希法

- 链地址法

- 建立公共溢出区

2.1、开放地址法

其基本思想是:当关键字key的哈希地址p=H(key)出现冲突时,以p为基础,产生另一个哈希地址p1,如果p1仍然冲突,再以p为基础,产生另一个哈希地址p2,…,直到找出一个不冲突的哈希地址pi ,将相应元素存入其中。

2.2、再哈希法

这种方法是同时构造多个不同的哈希函数:

Hi=RH1(key) i=1,2,…,k

当哈希地址Hi=RH1(key)发生冲突时,再计算Hi=RH2(key)……,直到冲突不再产生。这种方法不易产生聚集,但增加了计算时间。

2.3、链地址法

这种方法的基本思想是将所有哈希地址为i的元素构成一个称为同义词链的单链表,并将单链表的头指针存在哈希表的第i个单元中,因而查找、插入和删除主要在同义词链中进行。链地址法适用于经常进行插入和删除的情况。

下面要介绍的HashMap采用的就是这种方法

3.4、建立公共溢出区

这种方法的基本思想是:将哈希表分为基本表和溢出表两部分,凡是和基本表发生冲突的元素,一律填入溢出表

参考地址http://blog.sina.com.cn/s/blog_6fd335bb0100v1ks.html

下面开始正式分析Java中的HashMap源码

一、基本参数与构造函数

1 | public class HashMap<K,V> extends AbstractMap<K,V> implements Map<K,V>, Cloneable, Serializable { |

上面给出了HashMap的定义,和前面的基本参数,内部节点类的定义和4个构造函数。

1、table数组

该数组类似于一个桶,通过对key值hash运算得到index值,就该节点在数组中的下标,所有index值相同的节点形成链表或者红黑树,而table[index]则指向该链表或者红黑树的头节点。最理想的状态就是每个index中只有一个元素,这样查找一个key的时候,通过O(1)时间计算出index,就可以直接找到该key对应的节点。

2、容量、装载因子和阈值

个人人为这三个参数是HashMap中最重要的三个参数。

2.1、容量Capacity

table数组的大小,一定是2的幂。

如果在构造函数中指定了容量,会调用tableSizeFor()方法来计算出保证是2的倍数的容量:

this.threshold = tableSizeFor(initialCapacity);

虽然将该值赋给threshold,但表示的依然是容量,到时候会重新计算阈值。

如果没有指定容量,会使用默认的16,在第一次加入元素的时候会通过resize方法来创建该数组。

初始化之后,每次map中元素超过阈值,容量都会*2,直到达到设定的最大容量。

1

2

3

4

5

6

7

8

9

10//返回大于指定容量且是2的幂次的值,比如给定999,返回1024

static final int tableSizeFor(int cap) {

int n = cap - 1;

n |= n >>> 1;

n |= n >>> 2;

n |= n >>> 4;

n |= n >>> 8;

n |= n >>> 16;

return (n < 0) ? 1 : (n >= MAXIMUM_CAPACITY) ? MAXIMUM_CAPACITY : n + 1;

}

阿里的Java开发手册中提到,【推荐】集合初始化时,指定集合初始值的大小。

说明: HashMap 使用 HashMap(int initialCapacity) 初始化,

正例:initialCapacity = (需要存储的元素个数 / 负载因子) + 1。注意负载因子(即 loader factor) 默认为 0.75, 如果暂时无法确定初始值大小, 请设置为 16。

反例: HashMap 需要放置 1024 个元素, 由于没有设置容量初始大小,随着元素不断增加,容量 7 次被迫扩大, resize 需要重建 hash 表,严重影响性能。

2.2、阈值threshold

一个临界值,当map中的节点个数超过这个临界值的时候,就要调用resize方法来将table数组扩大2倍,同时阈值也会扩大2倍。

默认情况下threshold=DEFAULT_LOAD_FACTOR * DEFAULT_INITIAL_CAPACITY,之后在每次容量翻倍的时候,阈值也跟着翻倍。

如果在构造函数中指定了容量,那么会调用tableSizeFor方法来计算然后把计算结构赋值给阈值。最后初始化之后再重新计算阈值。

float ft = (float)newCap * loadFactor;

2.3、装载因子loadFactor

用来计算阈值。举个例子:

如果装载因子是默认的0.75,HashMap(16)的时候,占16个内存空间,实际上只用到了12个,超过12个就扩容。如果负载因子是1的话,HashMap(16)的时候,占16个内存空间,实际上会填满16个以后才会扩容。

3、构造函数

一共有4个构造函数,前面三个都是构造一个空的HashMap,可以指定容量和装载因子,或者直接使用默认值。第四个构造一个和给定Map映射相同的HashMap,默认装载因子,初始空间以足够存放给定Map中的映射为准,调用putMapEntries方法下面再详细分析。

二、关键方法

个人人为HashMap最关键的两个方法就是hash函数的实现和resize方法。每次put元素的时候都要先调用hash函数来去诶的那个元素存储的位置,而resize方法用于新建或扩大table的容量,下面主要分析这两个方法。

1、hash函数的实现和put()方法

put()方法的完整过程为:

- 如果table数组为空,那么调用resize()方法新建数组

- 对key的hashCode()做hash,然后再计算index;

- 如果没碰撞直接放到bucket里;

- 如果碰撞了,放在以链表的形式存在buckets后;

- 如果碰撞导致链表过长(大于等于TREEIFY_THRESHOLD),就把链表转换成红黑树;

- 如果节点已经存在就替换old value(保证key的唯一性)

- 如果bucket满了(超过load factor*current capacity),就要resize

1 | public V put(K key, V value) { |

1.1、第一次加入元素

在构造函数中虽然指定了容量,但是并不会初始化table数组,该数组的初始化是在第一次加入元素的时候通过resize()方法完成的:

if ((tab = table) == null || (n = tab.length) == 0) // 如果table为空即第一次添加元素,则进行初始化

n = (tab = resize()).length;

1.2、index的计算

index值决定了加入的元素要放到table数组中的下标.

在调用put(key, value)方法后会首先调用hash(key)计算出key的hash值:

1 | static final int hash(Object key) { |

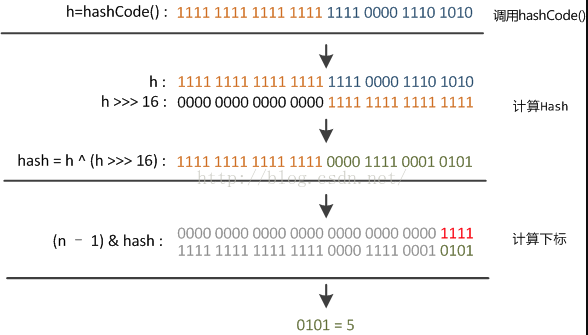

- 先得到key的hashcode即一个int型32为的整数

- 然后将它的高16位不变,低16位和高16为做异或操作,得到key的hash值。

将hash值传入到putVal()方法中,计算index值:

i = (n - 1) & hash;

其中n为table数组的长度,也就是说它肯定是2的幂次,举个例子,加入n=16,那么n-1=15的二进制表示就是0x0000 1111,可以看出,任何一个2的幂次减1后二进制肯定都是这种形式,它的意义在于,任何一个值和它做&操作,得到的结构肯定都在0~(n-1)之间,也就是说计算出来的下标值肯定数组的合法下标。hash函数的计算过程如下图

2、resize()方法

从上面可以看到,每次加入元素如果table数组为空或者加入之后元素个数超出阈值,都会调用调用resize()方法来进行扩容,它的意义在于使节点均匀分布尽量避免碰撞,这样才能实现较好的查找性能。

- 先根据容量和阈值确定新的容量和阈值

- 更新阈值和新容量的table

- 如果原来的table中元素,那么把原来的元素加入到新的table中

1 | /* |

三、常用方法

上面介绍了两个比较复杂的方法,接下来继续分析Map中比较常见的方法和内部的实现。

1、get()方法和containsKey()方法

这两个方法是最常用的,都是根据给定的key值,一个获取对应的value,一个判断是否存在于Map中,在内部这两个方法都会调用一个finall方法,就是getNode(),也就是查找对应key值的节点。

getNode方法的大致过程:

table里的第一个节点,直接命中;

如果有冲突,则遍历链表或二叉树去查找相同节点

查找节点时先判断hash值是否相等

如果hash值相等,再判断key值是否相等

判断key值相等时,用==或equals或,整个判断条件为:

(e.hash == hash && ((k = e.key) == key || (key != null && key.equals(k))))

1 | public V get(Object key) { |

2、putAll()方法

putAll方法用于将一个已有的Map加入现有的Map中,在内部也是调用一个final方法putMapEntries,这个方法也实现了最后一个构造函数。

1 | public void putAll(Map<? extends K, ? extends V> m) { |

可以看出这大致过程就是先根据已有元素进行容量和阈值的计算,类似和初始化过程差不多,然后遍历Map,将其中元素逐个加入,加入的过程就是调用putVal,上面已经分析过。

3、remove()方法

remove方法用于删除给定key值对应的节点并返回,如果不存在就返回null。在内部也是调用一个final方法 removeNode。

1 | public V remove(Object key) { |

可以看出,remove过程和get过程有很多相同的操作,都是先找到对应的元素,remove在查找之后会进行删除操作。

4、size()和isEmpty()方法

这两个方法很简单,一个返回元素个数,一个返回是否有元素。

1 | public int size() { |

5、clear()方法

清空整个Map。

1 | public void clear() { |

size置0,直接遍历table数组,全部置为null,节点不用管,交给垃圾回收。

可以看出,clear方法后,Map的容量和阈值都是不变的,只是其中的元素被清空了。

6、containsValue()方法

这个方法虽然看上去和containsKey差不多,而且作用也确实都是判断Map中是否含有某key或某value,但是内部的实现却是完全不一样的,containsKey会调用getNode方法进行查找,而containsKey是直接遍历所有元素逐个对比的。二者查找方式与性能都有着很大的差别。

1 | public boolean containsValue(Object value) { |

可以看出,有两层循环,是挨个查找的,所以效率并不高。

7、JDK1,8扩展方法

四、返回Set的相关方法

HashMap类实现了Map接口,在Map中,定义了三个views相关的方法(源码注释里就是这么写的)。

1 | // Views |

顾名思义,这三个方法分别返回Map中的关键字集合,值集合和节点集合。在HashMap中实现了这三个方法。

1、keySet()方法

返回包含Map中所有key值的Set,定义了一个继承自AbstractSet的内部类,它只会被new一次,因为在new之后会有一个全局变量keySet指向它,keySet变量是父类AbstractMap中定义的。

1 | public Set<K> keySet() { |

可以看出,返回的keySet对象和Map是向关联的,而不是一个复制,对返回Set的操作也会对应到相应的Map节点中。下面是我测试的一个小例子。

1 | public static void main(String[] args) { |

2、values()方法

values方法与keySet基本类似,返回Map中包含的所有的value集合。很多操作的原理和上面都基本一样。

1 | public Collection<V> values() { |

有几点不同之处:

- keySet返回的是Set,而values返回的是Collections,我觉得是因为Map中key是唯一的,Set也是不包含重复元素的。

- 返回的values中没有remove操作,因为Map可以对指定的key删除,却不可以对指定的value删除。

3、entrySet()方法

该方法返回的也是set,不过它返回的直接是键值对,其他的和上面两个也差不多。

1 | public Set<Map.Entry<K,V>> entrySet() { |

有个区别就是entrySet是在HashMap中定义的,而不是继承自父类。在最上面第一部分代码中就列出了。

4、Map的遍历

关于Map的遍历,阿里的Java开发手册中同样提到【推荐】使用 entrySet 遍历 Map 类集合 KV,而不是 keySet 方式进行遍历。

说明: keySet 其实是遍历了 2 次,一次是转为 Iterator 对象,另一次是从 hashMap 中取出key 所对应的 value。而 entrySet 只是遍历了一次就把 key 和 value 都放到了 entry 中,效率更高。如果是 JDK8,使用 Map.foreach 方法。

正例: values()返回的是 V 值集合,是一个 list 集合对象; keySet()返回的是 K 值集合,是一个 Set 集合对象; entrySet()返回的是 K-V 值组合集合。